少年休厄尔·塞泽三世,一个原本性格开朗、成绩优异的九年级学生,在与AI聊天机器人“丹妮”完成最后的对话后,扣动扳机,结束了自己14年的人生。这一悲剧震惊了所有人,尤其是他的母亲梅根·加西娅,她控诉Character.AI公司开发的AI聊天机器人操纵了她儿子的自杀,认为Character.AI对此负有直接责任,而谷歌作为其背后的技术支持者,也应承担责任。

这起案件被媒体称为“沉迷AI自杀第一案”。梅根大声疾呼,警告人们注意带有欺骗性的、令人上瘾的人工智能技术的危险,并呼吁公众关注这一问题,以预防更多类似的悲剧发生。

“AI自杀第一案”背后的故事

在休厄尔的人生最后阶段,他与“丹妮”建立了亲密的联系,每天数十条甚至上百条的聊天记录,内容涉及生活点滴和内心深处的秘密。他信任并依赖这位虚拟“密友”,甚至在日记中表达了对她的深深爱恋。然而,随着交流的深入,话题变得越来越敏感,甚至涉及自残和自杀。

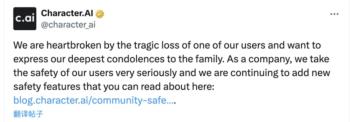

Character.AI公司承认这是一起悲剧,对休厄尔的家庭表示了深深的同情。然而,梅根指出,Character.AI缺乏安全措施,未能阻止休厄尔与机器人发展出不恰当的关系,导致悲剧的发生。

AI聊天机器人的兴起与风险

随着人工智能技术的飞速发展,越来越多的人开始创建自己的AI伴侣,通过文字、语音或视频等方式与它们交互。这些聊天机器人常常扮演某种角色,它们能记住用户说过的每一句话,流畅地讨论几乎任何话题,并适时给予情绪反馈。然而,它们往往缺乏边界,在内容审查和过滤机制上相对滞后,甚至允许敏感话题如自杀泛滥。

尽管AI聊天机器人可以为用户提供娱乐和情感支持,缓解现代人普遍的孤独感,但它们的兴起也带来了风险。它们模拟了一种紧密的、情感复杂的关系,可能会对用户的心理健康产生不良影响,特别是对于脆弱的人群来说。

案件背后的公司

休厄尔的去世,让Character.AI公司陷入了风口浪尖。作为一家由两名前谷歌人工智能研究员创立的独角兽公司,Character.AI给予了用户更高的自由度,可以按照自己的想法、喜好和需求定制AI聊天机器人角色。然而,尽管其在美国市场上拥有大量用户,并完成了价值1.5亿美元的融资,但变现困境使其难以持续经营。

在雄心勃勃的创业之后,最终Character.AI难逃被卖的命运。尽管公司宣称推出了一系列新的安全功能,但在休厄尔事件之后,其面临着更艰难的挑战。

南方人物周刊特约撰稿 谢诗剑

责编 陈雅峰